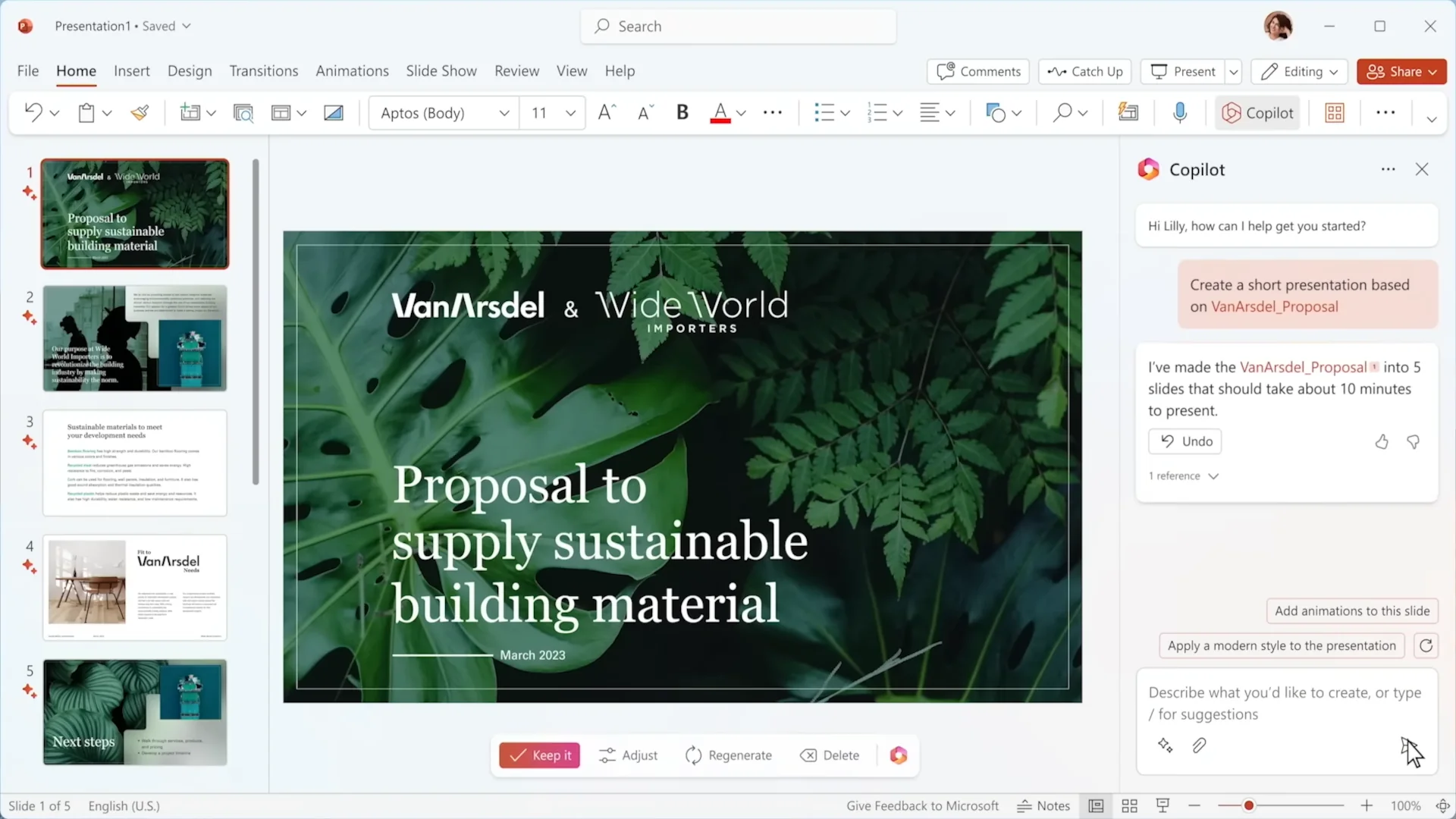

Microsoft se chystá integrovat nového AI Copilota do balíku software Microsoft 365.

Mnozí experti však varují, že Copilot není plně připraven pro podniky. Avivah Litan (VP analyst, Gartner) uvedla, že Copilot není plně enterprise-ready. Má se to týkat zejména regulovaných odvětví. Prozatím prý neodpovídá regulacím jako GDPR a Artificial intelligence act.

Potíže vyplývají zejména z toho, že Copilot je také založen na rozsáhlých jazykových modelech (GPT-3, GPT-4, DALL-E, Codex a podobně).

Možné potíže s AI a rozsáhlými jazykovými modely ve firemním prostředí

Ochrana dat

Pro firmy je obtížné garantovat, že data jsou v bezpečí, jelikož je málo veřejně dostupných informací o rozsáhlých jazykových modelech.

Citlivé informace mohou uniknout do jazykového modelu. U Samsungu měli takový incident a vedlo to až k zákazu používat ChatGPT, Bard a Bing.

Protože rozsáhlé jazykové modely fungují jako uzavřená schránka, není možné pro firemního zodpovědného pracovníka jednoduše zjistit co se nachází uvnitř.

Halucinace

Rozsáhlý jazykový model může poskytovat nesprávné informace, protože do něj uživatelé takové informace zadali.

Jednou z dalších výzev je jak účinně odfiltrovat nevhodná témata, či informace, které se různě odchylují od normálu.

Útoky hackerů a získání neoprávněného přístupu k výstupům

Útok typu prompt injection může pomoci útočníkům získat přístup k výstupům z jazykového modelů. Takto mohou získat přístup k citlivým informacím. Mluvčí MS sice vyvrátil tuto možnost u Copilota, ale Litan je jiného názoru.

Microsoft má vyvinutý systém

Mluvčí Microsoft dále poskytl informace o vyvinutém bezpečnostním systému a o velkých teamech, které pracuji na vyřešení problémů s dezinformacemi, filtrováním obsahu a prevenci propagace škodlivého a diskriminačního obsahu.

Závěrečné doporučení

Přes všechna ujištění se doporučuje uživatelům, aby nevkládali do AI modelů (typicky do promptů) žádné soukromá, citlivá či jinak interní data (předmětem duševního vlastnictví) kvůli nebezpečí, že mohou být zpřístupněna neautorizovaným osobám.